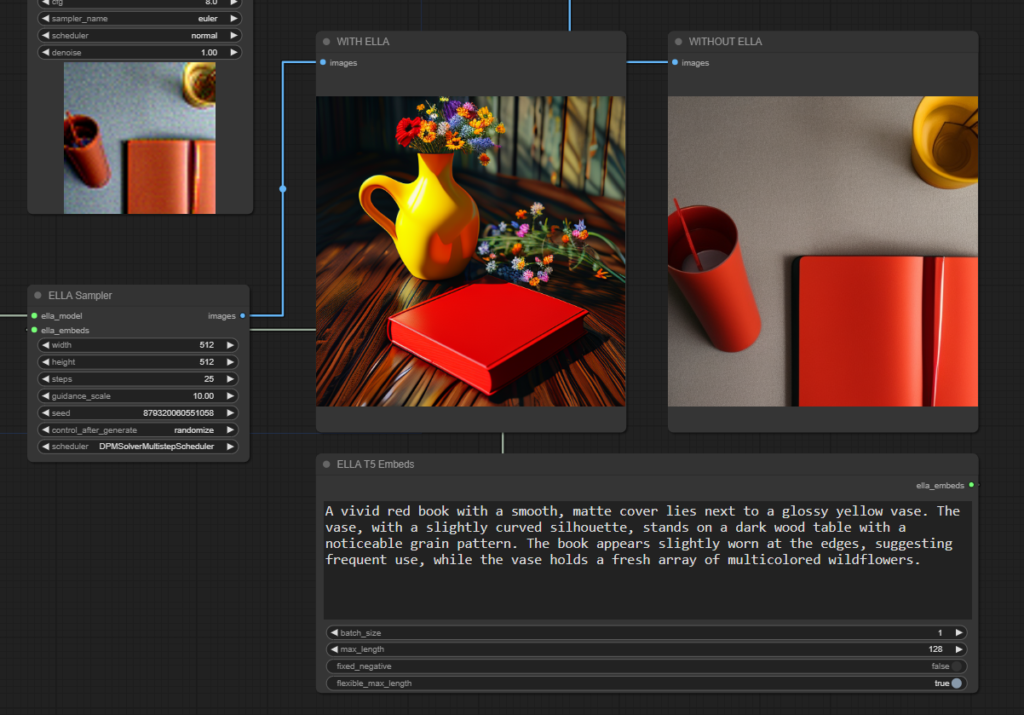

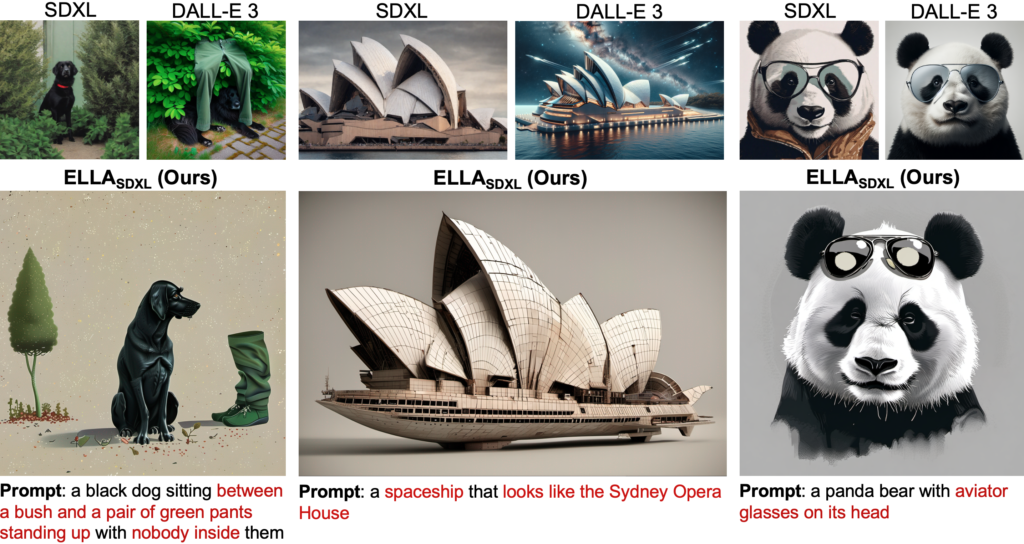

I modelli di diffusione hanno dimostrato un’eccezionale capacità di generare immagini a partire da testo, tuttavia, la maggior parte di questi modelli utilizza ancora CLIP come encoder di testo, che limita la loro capacità di comprendere prompts densi, che comprendono più oggetti, dettagliati attributi, relazioni complesse e allineamento di lungo testo. Per affrontare questo problema, è stato introdotto ELLA: Equip Diffusion Models with LLM for Enhanced Semantic Alignment.

ELLA è un adattatore efficiente di grandi modelli linguistici (LLM) che migliora i modelli di diffusione basati su CLIP con potenti LLM per migliorare l’allineamento del testo senza la necessità di addestrare U-Net o LLM. Questo approccio utilizza un’ampia gamma di design di connettori di allineamento semantico per unire in modo fluido due modelli pre-addestrati e propone un nuovo modulo, il Timestep-Aware Semantic Connector (TSC), che estrae in modo dinamico condizioni dipendenti dal timestep da LLM.

Il TSC adatta le caratteristiche semantiche in diversi stadi del processo di denoising, assistendo i modelli di diffusione nella comprensione di prompts lunghi e complessi durante il processo di campionamento. ELLA può essere facilmente incorporato con modelli e strumenti della comunità per migliorare le loro capacità di seguire i prompt. Per valutare i modelli di text-to-image in termini di seguire i prompt densi, è stato introdotto il Dense Prompt Graph Benchmark (DPG-Bench), un benchmark impegnativo composto da 1K prompts densi.